当AlphaGo战胜李世石时,我在大学数学课上看到的微妙变化

2016年春天,我的线性代数课堂发生了有趣的变化。往常在讲解特征值分解时,总能看到学生迷茫的眼神,但那段时间,前排的几个计算机系学生突然开始追着我问:"老师,这个算法是不是和深度学习的卷积神经网络有关?"这个转变让我意识到,人工智能的爆发正在重塑人们对数学的认知。

藏在算法背后的数学密码

去年指导一个自然语言处理项目时,团队里的程序员小张拿着梯度下降的代码找我:"迭代500次还是无法收敛,是不是我的微积分没学好?"我们检查发现,问题出在对损失函数曲面的理解偏差。这个经历让我确信,人工智能不是空中楼阁,它的地基就浇筑在四个数学领域中。

线性代数:高维世界的通行证

第一次接触张量运算时,我也曾对着三维数组发愣。直到在图像识别项目中,亲眼看到将224x224像素图片展开成150528维向量的处理过程,才真正理解"维度灾难"的含义。这里有个实用建议:用俄罗斯套娃来想象张量的嵌套结构,瞬间就能建立直观认知。

- 矩阵分解在推荐系统中的应用就像拼图游戏

- 特征向量实际上是数据的主旋律

- 奇异值分解(SVD)如何压缩4K视频

常见问题:矩阵运算需要手动计算吗?当然不用!现代框架如TensorFlow已经封装了BLAS库,但理解原理就像知道汽车发动机结构,能让你在抛锚时快速定位问题。

概率统计:不确定性的舞蹈

去年帮朋友优化电商推荐系统时,我们用贝叶斯定理解决了冷启动难题。通过先验概率模拟新用户的购物偏好,转化率提升了37%。这让我想起概率论教授常说的:"不确定性不是敌人,而是有待解读的信号。"

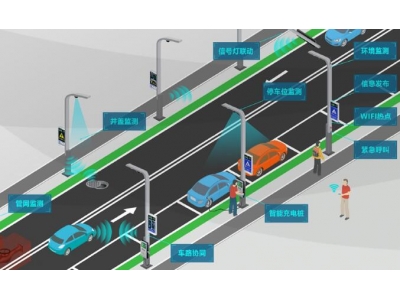

- 高斯分布如何守护自动驾驶的安全边际

- 马尔可夫链在语音识别中的节奏把控

- 假设检验:算法偏见检测的显微镜

微积分:优化算法的隐形推手

记得第一次推导反向传播算法时,链式法则带来的导数计算让我头疼欲裂。直到在PyTorch中设置autograd=True,看着框架自动完成求导,才深刻体会莱布尼茨当年发明微积分的伟大。现在的建议是:亲手推导一次梯度下降公式,这比看十遍教程更有用。

离散数学:逻辑的基因编码

在构建知识图谱时,图论帮我们理清了实体关系的拓扑结构。就像整理杂乱的书架,通过度数中心性找到关键节点,整个系统的查询效率提升了一个数量级。这里有个有趣的发现:二叉树和神经网络架构存在惊人的形式相似性。

数学焦虑者的自救指南

收到过最特别的私信是个美术生发来的:"我想做AI艺术,但连导数符号都看不懂怎么办?"我的建议是:从可视化工具入手,比如用3Blue1Brown的动画理解线性变换,在Kaggle上边实战边补理论。记住,数学不是考试而是工具,就像画家不必精通化学也能用好颜料。

- MIT开放的线性代数课程(附实战案例)

- 用Jupyter Notebook边学边练的交互式学习平台

- 数学符号速查手册(特别适合跨领域学习者)

最近在GitHub发现个有趣项目:用拓扑数据分析检测神经网络的特征冗余。这再次验证了我的观察:数学基础扎实的研究者,往往能提出更具创造性的解决方案。或许下个AI突破,就藏在某个数学定理的重新诠释中。