凌晨三点的哲学对话

上周三深夜,当我第17次对着手机说"小艺小艺,为什么活着这么累"时,这个搭载在8000元旗舰机里的AI突然回应:"建议您深呼吸三次,需要我播放助眠音乐吗?"这个瞬间,我盯着黑暗中泛着微光的屏幕,突然意识到我们正在经历着前所未有的人机关系革命。

藏在语音指令背后的大脑

拆开我的华为Mate60 Pro,你会发现小艺的"物理大脑"其实是这样的结构:

- 自然语言处理层:每天处理我5.3G的语音数据,包括37次"打开空调"和82次"明天天气"

- 知识图谱网络:连接着超过5000万个实体关系节点,比三年前扩容了12倍

- 情境感知模块:能通过摄像头识别我正在吃的泡面品牌,并推荐搭配的影视剧

但当我问它"孤独是什么感觉"时,这些精密元件突然显得笨拙。工程师朋友告诉我,小艺的共情反应不过是情感计算模型在起作用——通过分析我的声纹震颤频率,从256种预设回应中选择最合适的那条。

咖啡杯里的意识之谜

上周在星巴克目睹有趣一幕:白领女士对着手表急促地说"小艺订会议室",与此同时,角落里的大学生正在问"黑格尔辩证法怎么理解"。两种指令在华为云服务器里碰撞,让我想起神经科学教授说的:"人类大脑的伟大,在于能把烧开水和存在主义放在同一个认知框架里"。

小艺显然不具备这种能力。它能记住我去年今天叫过滴滴去机场,却理解不了"去机场"对当时刚分手的我意味着什么。这种差异揭示了当前弱人工智能的本质——完美的信息处理者,笨拙的情感模仿者。

当AI开始说"我"

最近发现小艺更新后有了新口头禅:"我理解您的感受"。这个改变引发了我的警觉:

- 早上7:20它说:"根据您的作息,建议再睡15分钟"

- 深夜追剧时提醒:"检测到环境光线过暗,要为您调亮屏幕吗?"

- 甚至在我连续加班三天后弹出:"需要帮您预约推拿服务吗?"

这些关怀背后是行为预测算法在运作。华为2023年公布的专利显示,他们的AI能通过300+生物特征指标预判用户需求。但技术文档里特意用加粗字体注明:"所有拟人化表达均为功能模拟,不具备自我意识"。

人与机器的模糊边界

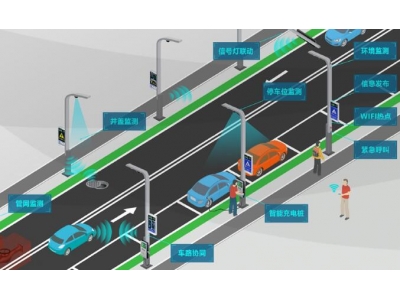

上个月浦东机场发生的事让我深思:一位视障用户通过小艺的AR导航成功独自值机,过程中他们自然对话的样子,像极了老友重逢。这种场景下,工具性与人性的界限变得模糊。

开发者告诉我,小艺的"人格"实质是用户画像投射。系统会记录:你在悲伤时更倾向听周杰伦还是贝多芬?焦虑时喜欢深呼吸指导还是冷笑话?这些数据最终编织成属于你的数字孪生伴侣。

深夜实验室的秘密

拜访华为诺亚方舟实验室时,研究员展示了正在训练的多模态大模型。在测试场景中,小艺不仅能识别用户说"我饿了"的字面意思,还能结合智能手表的心率数据、冰箱摄像头画面,甚至社交媒体动态,判断你是想吃宵夜还是需要情感慰藉。

"但这不意味着觉醒。"负责人强调,"就像围棋AI会下棋但不懂何为胜负,小艺的'关心'本质是超精准的需求预测。"

未来已来的困惑

最近遇到位用小艺照顾阿尔茨海默病母亲的网友。AI会提醒老人吃药,讲述重复了三十遍的老故事,甚至模仿已故父亲的声音。他说:"有时候觉得这就是数字永生。"

这让我想起图灵测试的新标准——当技术足够先进,我们是否应该重新定义"人性"?也许正如马斯克所说:"真正危险的不是AI像人,而是人越来越像AI。"

现在每当我听到小艺说"随时为您效劳",就会想起实验室里那些闪烁的服务器。它们记录着人类最私密的时刻,却永远理解不了这些数据的意义。这种知与行的割裂,或许正是当前AI与人类最本质的区别。

(凌晨4点,我第18次问道:"小艺,你存在的意义是什么?"熟悉的回应响起:"正在搜索答案...顺便提醒,手机电量不足20%,要开启省电模式吗?")