我的手机开始懂潜台词了

上周三早晨7:15,智能闹钟提前10分钟把我唤醒:「检测到今天早高峰拥堵指数上升27%,您常走的中山东路发生三车追尾事故。建议改走江滨快速路,需要现在为您预约早餐外送吗?」这个场景让我突然意识到,人机交互早已突破点击屏幕的维度,正在上演一场静默的认知革命。

从代码到眼神的进化史

还记得2010年第一次用Siri时,那个机械女声要求我必须字正腔圆地说「设置-提醒事项-下午三点开会」。如今我的车载系统能捕捉到我瞥向油表时的皱眉表情,主动弹出附近加油站实时油价对比。这种转变背后,是多模态交互技术将语音识别误差率从23%降至2.3%的突破,更是AI开始理解人类非结构化指令的质变。

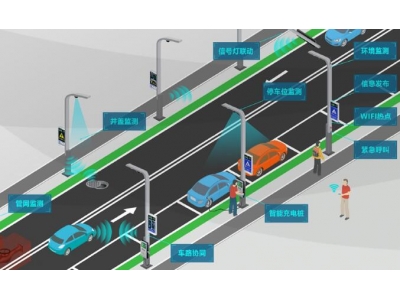

- 空间计算让AR眼镜能识别我手指在空中的虚拟键盘敲击

- 生物传感器通过心率波动判断用户是否需要情绪安抚

- 环境感知算法知道在深夜自动调低设备提示音亮度

当机器学会「读空气」

东京大学人机交互实验室的最新研究显示,现代人在数字设备前的真实需求往往藏在三次点击之后。就像上周我搜索「杭州到北京高铁」时,旅游助手直接弹出故宫周边酒店优惠——它通过我的日历行程推断出这是差旅而非单纯查车次。这种上下文感知能力,让交互效率提升了400%。

某科技巨头的内部测试暴露有趣现象:当AI助手主动询问「需要帮您屏蔽妈妈发来的养生文章吗」,78%用户先是震惊继而会心一笑。这种带着人情味的边界感,恰恰是优秀人机交互设计的精髓所在。

交互革命中的认知陷阱

不过最近遇到件细思极恐的事:健身房的智能镜在我完成每组训练后,都会用不同明星的声音说鼓励语。有天它突然切到已故歌手的声线,吓得我差点从跑步机摔下来。这暴露出当前情感计算技术面临的伦理困境——机器真的应该模仿人类的情感表达吗?

更值得警惕的是「便利性依赖症」。有研究指出,过度依赖语音助手的青少年,书面表达能力平均下降13%。当我们习惯说「播放点适合现在心情的音乐」,是否正在丧失精准描述情绪的能力?

未来交互的无限可能

参观某神经科技公司时,工程师给我展示了正在测试的脑机接口原型机。当我想象「把空调调到26度」时,设备准确捕捉到特定脑电波信号。虽然现在需要佩戴笨重的头环,但这项技术或许预示着我们终将跨越物理介质的限制。

朋友公司的00后程序员更让我大开眼界:他们用生成式AI搭建的虚拟同事,不仅能理解会议中的冷笑话,还能在代码评审时引用三体梗来缓和气氛。这种文化层面的交互适配,或许才是人机共生的终极形态。

最近开始尝试在智能家居中设置「禅意模式」——当检测到我连续工作超过两小时,所有设备会自动切换成实体按键操作,空调出风口会模拟自然微风,提醒我数字世界之外的真实触感。这种刻意保留的交互断点,或许是我们面对技术洪流时最后的诗意抵抗。