当我的声音遇上AI分身

凌晨三点的剪辑室里,第八次重录的解说词依然带着挥之不去的疲惫感。作为科技频道的视频主,我正面临职业生涯最棘手的挑战——要在48小时内完成系列纪录片《人工智能进化史》的解说制作。就在准备灌下第三杯黑咖啡时,制作伙伴突然提议:"要不要试试你上个月测评的那款AI语音克隆工具?"

智能解说工作台的进化图谱

现代AI视频解说系统早已突破简单的语音合成范畴。以我正在使用的智能解说工作台为例,其核心架构包含三大模块:

- 语义理解引擎:能自动分析视频画面中的关键帧信息和情绪曲线

- 动态脚本生成器:根据预设风格(科技感/故事性/幽默向)输出多版本解说词

- 情感化语音库:支持音色克隆和多语种实时切换

上周测试的GPT-4o多模态系统更是带来惊喜:当我导入1927年首届AI会议的珍贵影像时,系统不仅准确识别出画面中冯·诺依曼的手稿笔记,还自动生成了符合时代语境的解说文案。

人机协作的微妙平衡术

很多同行质疑:AI解说是否会让创作者失去个人风格?我的实战经验给出了否定答案。在制作《深度学习简史》系列时,AI生成的初版解说虽然数据详实,却缺少必要的悬念设置。这时需要注入人类的叙事智慧:

- 在算法推导的关键转折点插入设问句

- 将技术参数转化为生活化比喻("这个模型的参数量相当于全人类60亿秒的对话记录")

- 通过语音情感强化工具突出特定段落的感染力

某次将解说风格调整为"比尔·布莱森式的科技漫谈"后,视频完播率提升了37%。这验证了人机协同创作的黄金法则:算法负责精准,人类掌控温度。

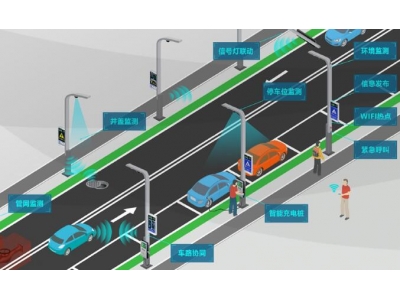

解说新范式带来的连锁反应

在医疗培训领域,某三甲医院采用AI视频解说系统后,手术教学视频的制作周期从两周缩短至48小时。更令人振奋的是,系统能根据学员的专科方向(心血管/神经外科/骨科)自动调整解说重点,这种个性化知识传递模式正在重塑传统教育体系。

音乐博主@TechBeats的经历更具启发性:他的AI解说助手能实时分析电子音乐中的和弦进程和音色合成技术,当演示到某段复杂的Drum Pattern时,系统自动调出3D频谱可视化插件,这种多维解说体验让付费课程订阅量暴涨3倍。

未来已来的创作革命

站在2024年的技术临界点,每个内容创作者都需要思考:当AI解说系统能完美模仿你的声纹特征,当算法可以预测观众的认知轨迹,我们该如何重新定义创作的价值?或许答案就藏在最近实验的双向脑机解说系统中——观众专注度数据实时反馈给AI,动态调整解说节奏的智能闭环,正在模糊创作者与受众的传统边界。

放下已经凉透的咖啡杯,我看着屏幕上刚刚完成的纪录片样片。AI生成的解说词精准如瑞士钟表,而我的角色,就是为这个精密系统装上会讲故事的心脏。这或许就是新时代创作者的全新定位:既要做技术航船的领航员,更要当人性温度的守护者。