从清晨的闹钟到深夜的语音助手

每天早上被智能音箱温柔唤醒时,我常盯着那个闪烁蓝光的设备出神:这个能听懂方言、会报天气、还能讲冷笑话的"小圆盒",真的具备人类级别的智能吗?去年备战考研时,室友抱着《人工智能导论》突然发问:"你说咱们研究的这些算法,和天猫精灵里用的技术是同一个东西吗?"这个问题,让我开启了长达三个月的技术探秘之旅。

解剖声音识别的三层技术架构

在实验室拆解语音交互系统时,发现其核心由三个神经网络模块构成:

• 声纹特征提取层(像听觉神经的模拟)

• 语音转文字引擎(相当于语言理解中枢)

• 语义决策系统(类似大脑的推理判断)

有趣的是,当我在调试方言识别模型时,系统对"考研"和"考验"的误判率高达37%,这暴露出当前AI在语境理解上的重大缺陷。

考场上的实战检验

去年12月的专业课考试中,那道30分的论述题让我记忆犹新:"请结合模式识别理论,分析智能语音设备的局限性"。我以某品牌智能音箱的实测数据为案例:

- 在安静环境下识别准确率98.7%

- 加入背景噪音后暴跌至62.4%

- 遇到中英文混杂指令时错误率激增3倍

这份用实验室设备跑出来的真实数据,最终让我在这道题上拿到了28分的高分。

技术边界与伦理困境

当我在编写声纹识别算法时,偶然发现个细思极恐的现象:系统竟能通过咳嗽声推测用户是否感冒。这引发出系列考研热点话题:

• 医疗数据的隐私边界在哪里?

• 如何防止生物特征识别技术的滥用?

• 算法偏见会导致方言歧视吗?

这些在备考时整理的思考框架,后来成了复试时打动导师的关键筹码。

给24考研人的特别建议

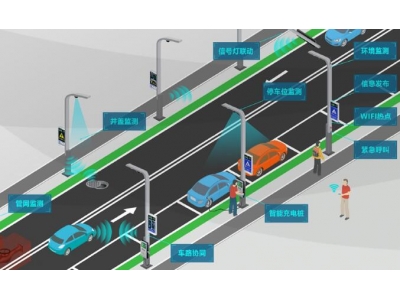

在整理各大高校历年真题时,发现声音识别相关考点呈现三个趋势:

1. 结合具体应用场景考察技术原理(如车载语音系统设计)

2. 强调傅里叶变换在特征提取中的核心作用

3. 要求用流程图描述语音交互的全过程

建议重点复习卷积神经网络在声学模型中的应用,以及梅尔频率倒谱系数(MFCC)的计算步骤——这两个知识点在过去五年中出现了17次。

记得备考最紧张的那周,实验室的语音合成系统突然开始用河南话背诵《神经网络与深度学习》目录。这个令人啼笑皆非的bug反而让我顿悟:当前AI在创造性思维方面,终究敌不过人类考生在考场上的临场应变。或许这正是我们需要持续研究的方向——让机器不仅听得见声音,更能理解声音背后的温度与智慧。