当自动驾驶汽车撞上护栏时,我在想什么

去年参与某车企的智能驾驶项目时,我们团队在封闭测试场目睹了惊险一幕:装载最新算法的测试车突然偏离预定路线,径直撞向隔离带。事后排查发现,问题竟出在训练数据中的一组模糊标注——某个角度的护栏图像被错误标记为"可穿越区域"。

这个经历让我深刻意识到,人工智能系统本质上是用数据浇筑的思维宫殿。就像建筑质量决定房屋抗震能力,数据质量直接左右AI系统的可靠性。当我们谈论AI落地难的问题时,往往忽略了最底层的数据地基是否夯实。

数据治理的三大致命陷阱

在接触过30+AI项目后,我发现企业常陷入这些数据困局:

- 数据沼泽现象:某金融科技公司存储了PB级的用户行为数据,但80%的字段缺乏元数据说明,就像图书馆里堆满未编目的书籍

- 标注黑箱操作:某医疗AI初创团队为赶进度,将CT影像标注外包给非专业人员,导致模型将正常组织误判为病灶

- 数据时间胶囊:某零售企业的推荐系统仍在使用三年前的消费数据,完全忽略了疫情后的消费习惯剧变

更棘手的是,这些问题往往在模型训练后期才暴露。就像用掺沙的水泥盖楼,等发现结构裂缝时,推倒重来的成本已难以承受。

数据治理的"黄金三原则"

在与头部AI公司合作过程中,我们总结出这些实战经验:

- 数据质量≠数据量:某语音识别团队将10万小时录音压缩到1万小时精标数据后,识别准确率反而提升12%

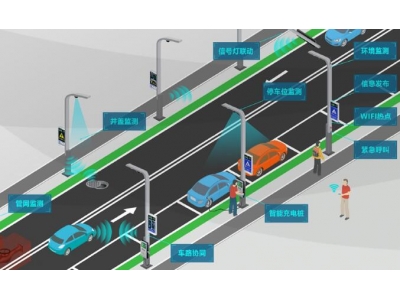

- 动态治理机制:某智慧城市项目建立数据"保鲜指数",对交通流量数据实施小时级更新验证

- 可解释性标注:某工业质检系统要求标注员不仅标出缺陷位置,还需记录判定依据和不确定度

最近帮助某银行搭建反欺诈系统时,我们创新性地引入数据血缘追踪技术。每个数据特征都能追溯其采集设备、清洗过程和版本变更,就像给每个数据细胞装上了溯源芯片。

AI工程师不会告诉你的数据真相

在算法狂欢的背后,数据治理工程师们正在打一场静悄悄的革命。某次行业闭门会上,头部公司的数据架构师透露:他们团队40%的时间花在数据治理,这个比例还在持续上升。

更令人震惊的是,某知名AI芯片厂商的测试数据显示:当训练数据错误率从5%降至1%时,芯片能效比可提升3倍以上。这说明优质数据不仅能提升模型效果,还能优化硬件资源消耗。

未来已来的数据治理新战场

随着多模态AI和具身智能的兴起,数据治理面临全新挑战:

- 某元宇宙平台正在建立3D模型的材料物理属性数据库

- 脑机接口公司开始规范神经信号的数据采集协议

- AI绘画引发的版权争议催生新型数据溯源标准

最近参与制定的《生成式AI数据治理白皮书》中,我们特别强调数据伦理评估前置机制。就像建筑项目需要环评,每个AI系统在数据采集阶段就要进行伦理影响评估。

站在AI爆发的临界点上,我常想起那个撞坏的测试车。当行业都在追逐更复杂的算法架构时,或许我们应该回到起点,重新审视那些构成AI生命线的数据颗粒。毕竟,再聪明的AI,也跳不出喂养它的数据围城。