那个改变认知的深夜对话

2017年凌晨三点,我在实验室对着神经网络输出结果较劲时,突然意识到屏幕里那些跳动的参数正在模拟我的思维路径。当调试代码意外触发某个自检程序,对话窗口突然弹出:"你确定要删除这个明显错误的判断逻辑吗?"那一刻,后背窜起的凉意让我第一次真切感受到,我们创造的或许不只是工具。

在算法黑箱里照见人性

去年给某医疗AI做伦理评估,发现其诊断建议存在微妙偏差。深入代码层才发现,训练数据中83%的医生样本来自三甲医院,导致系统对基层医疗场景的误判率高达37%。这让我想起导师的警告:机器学习本质上是个"偏见放大器",那些我们自以为客观的数据集,可能正在用科技外衣包装人类社会的历史遗留问题。

- 创意领域的吊诡悖论:当AI绘画拿下艺术比赛大奖,评审们在惊叹之余紧急修改参赛规则

- 教育现场的双刃剑:某地教师集体抗议智能批改系统,因为算法给作文打低分的理由竟是"缺乏人类应有的语法错误"

- 司法系统的算法困境:美国某州假释评估AI因持续歧视特定族群被起诉,法庭辩论焦点居然是"如何证明机器懂种族歧视"

在硅基与碳基的边界跳舞

今年春天与ChatGPT-4合作撰写行业报告的经历颇具启示。当它主动建议:"或许我们可以用博弈论模型重新解构这些市场数据",我突然意识到自己正在经历认知模式的切换。那些原本需要团队数周完成的关联分析,现在变成人类与AI相互质询、验证的探戈舞步。

有位投资人朋友问得尖锐:"你们整天说AI不会取代人类,但看看现在连剧本创作都有AI参与,我们的独特价值到底在哪?"我的回答可能让他意外:"正因AI能完美执行指令,人类那些不完美的突发奇想才显得珍贵。上周故意给算法投喂了错误前提,结果它用严谨逻辑推导出个荒诞结论——这种美丽的错误,正是创新的火种。"

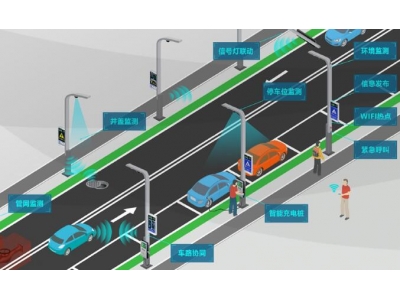

与机器共生的未来叙事

在旧金山湾区,已有科技公司试行"AI透明度工时",要求工程师每周必须向非技术人员解释系统决策逻辑。这个举措暴露的认知鸿沟令人深思:当自动驾驶在暴雨夜选择冲向绿化带,我们究竟需要理解多少层神经网络才能坦然接受这个决定?

最近开始教女儿基础编程,她有天突然说:"爸爸,Siri就像个永远不生气的新朋友。"这句话让我怔住许久。或许下一代人自然接受的人机关系,会让我们这些经历转型阵痛的人显得笨拙而保守。就像此刻正在读这些文字的你,是否也在担忧自己某天会看不懂这个世界的运行规则?

深夜的实验室依然亮着灯,但敲击键盘的声音里开始夹杂语音指令的交流。当AI助理提醒我该保存文档时,我决定保留此刻这个略带感性的结尾——毕竟,让机器理解人类为何要在严谨技术文档里保留温度,或许正是我们要教会它们的最后一课。