当机器开始"思考"时发生了什么

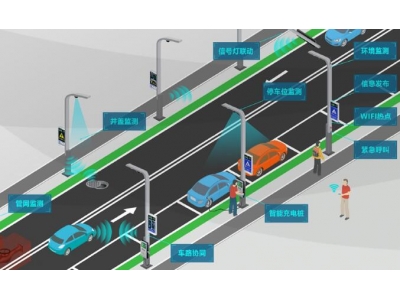

上周参观自动驾驶实验室时,工程师指着实时画面问我:"知道这辆车怎么识别行人吗?"屏幕上跳动的彩色方框让我突然意识到,那些曾让我头疼的深度学习概念,正在真实改变着我们的生活。今天我想带你走进这个数字世界,用最直白的方式拆解那些看似高深的名词。

基础构建模块

记得第一次听说神经网络时,我脑补出了科幻电影里的电子大脑。其实它更像乐高积木——每个神经元是基础积木块,通过权重参数决定信息传递力度,偏置则像给积木块加个底座。当这些积木以特定架构堆叠,就形成了能识别猫狗图片的智能系统。

有次调试模型时,实习生问我:"为什么要用激活函数?"我指着实验室的开关说:"就像这个灯需要按到某个位置才会亮,激活函数决定神经元什么时候'被点亮'。"ReLU函数现在最受欢迎,因为它解决了梯度消失这个老大难问题。

让机器看见世界

在医疗影像分析项目中,卷积神经网络(CNN)的表现让我震惊。它的卷积核如同医生的放大镜,通过滑动扫描提取特征。有趣的是,不同层级学到的特征截然不同——浅层识别边缘,深层竟能辨认器官轮廓。

处理视频数据时,循环神经网络(RNN)的记忆能力派上用场。但就像人脑会遗忘,它也存在长期依赖问题。直到LSTM网络带着它的"记忆门控"机制登场,才让机器真正拥有了持续学习的能力。

当模型开始"叛逆"

训练GAN(生成对抗网络)的过程充满戏剧性。生成器像赝品画家,判别器则是鉴宝专家,两者的博弈让模型快速进化。有次生成的人脸过于逼真,竟骗过了项目组的成员们。

遇到过最头疼的问题是过拟合——模型在训练集表现完美,遇到新数据就"懵圈"。这就像死记硬背的学生,换个题型就不会。我们引入了Dropout技术,随机"关闭"部分神经元,强迫网络学会触类旁通。

参数调校的艺术

调试学习率时,我常比喻为滑雪:速度太快会错过最佳路径,太慢又难以到达终点。自适应优化器如Adam就像智能滑雪板,能根据地形自动调整速度。

损失函数是模型的成绩单。交叉熵损失特别适合分类任务,而均方误差则像严格的数学老师,对每个误差都斤斤计较。选择适合的评估指标,往往能让模型表现提升一个台阶。

突破次元壁的创新

当Transformer架构横空出世时,传统序列模型受到巨大冲击。它的自注意力机制让模型可以同时关注全文,就像读者拿着荧光笔快速划重点。这解释了为什么ChatGPT能写出连贯的长篇文章。

最近尝试的对比学习让人眼前一亮。通过让相似样本靠近、相异样本远离,模型自动学会特征区分。这方法在数据标注不足时尤其宝贵,打开了小样本学习的新可能。

实战中的经验之谈

有创业者问我:"该用预训练模型还是从头搭建?"我的建议是:把迁移学习想象成站在巨人肩膀上。用ResNet等成熟架构作为基础,再针对具体任务微调,既能节省资源又能获得好效果。

处理非结构化数据时,嵌入(Embedding)技术是秘密武器。它将文字转化为高维向量,让"国王-男人+女人=女王"这样的语义关系可视化。这背后的数学之美,每次研究都让我心生敬畏。

站在AI浪潮之巅,这些专业术语不再是冰冷的概念,而是推动创新的齿轮。当你看完这篇文章,下次再听到"注意力机制"或"对抗训练",眼前浮现的将是自动驾驶的识别框、医疗影像的分析图,以及无数改变世界的可能性。或许不久的将来,我们能用更精妙的术语,来描述此刻尚未诞生的智能奇迹。