当算法开始教算法学习

三年前在谷歌DeepMind实验室,我目睹了一个有趣的场景:工程师给AI系统下达指令后,这个系统竟然自主生成了12种新型神经网络架构。更令人惊讶的是,其中有个名为"自进化拓扑"的模型,在图像识别任务中比人工设计的模型快了3倍。这标志着一个新时代的到来——人工智能正在重塑自身的训练方式。

突破传统训练的三重门

在传统网络训练中,工程师们需要像照顾新生儿般小心翼翼:

- 超参数迷宫:学习率调0.01还是0.001?这个问题曾经让整个团队争论三天

- 数据饥渴症:某医疗AI项目因缺少罕见病数据,准确率卡在83%整整半年

- 硬件囚徒困境:价值百万的GPU集群,利用率却长期徘徊在40%以下

如今走进微软Azure的AI实验室,会看到完全不同的景象:自动化训练系统正在同时优化300个模型的架构参数,就像一位同时指导整个交响乐团的大师指挥家。

AI赋能的实战工具箱

最近在训练一个工业质检模型时,我亲历了这样的转变:

- 元学习调度器:自动调整batch size的AI模块,让训练速度出现戏剧性变化。某次在128到2048之间动态调整,节省了47%的显存

- 对抗性数据工厂:生成包含细微缺陷的合成产品图像,将漏检率从5‰降至0.3‰

- 梯度手术刀:智能剪枝算法在迭代中精准定位冗余连接,模型体积缩小60%却提升了3%的准确率

训练场上的量子跃迁

英伟达最新发布的AI训练加速芯片里藏着个彩蛋——内置的强化学习控制器。这个指甲盖大小的模块,能实时分析数万个训练指标,自动调整计算资源分配。某次自然语言处理任务中,它把transformer模型的并行计算效率提升了惊人的82%。

更颠覆性的突破来自去年NeurIPS会议:MIT团队展示的自监督课程学习系统,能够根据模型当前状态自动设计训练计划。就像给运动员配备智能教练,在力量训练的间隙插入柔韧性练习,使整体训练效果产生质的飞跃。

当AI开始质疑人类

在优化某个推荐系统时,算法给出了反直觉的建议:将用户行为序列的观察窗口从30天缩短到18天。起初团队持怀疑态度,但上线后CTR提升了9.6%。事后分析显示,系统发现了"用户兴趣衰减曲线"中存在两个相位变化的临界点。

这种算法洞察力正在改变研发流程。现在我们的标准操作流程中,AI建议必须经过"可解释性审计",通过特征反演等技术解读其决策逻辑,这本身又催生出新的研究方向。

训练民主化运动

AutoML技术带来的变革最令我感慨。记得曾有个大学生团队用Google的AutoML Vision,仅用200张标注图片就训练出可用的病虫害识别模型。这在五年前需要博士团队和数万标注数据才能实现。

- 架构搜索平民化:NAS技术使网络设计从艺术变为科学

- 超参数自动化:贝叶斯优化算法取代网格搜索

- 灾难性遗忘疫苗:持续学习技术让模型获得终身学习能力

暗物质与可见光

在欣喜之余,我们也必须正视新挑战。去年某金融风控模型出现的"优化幻觉",就是典型教训:在训练集上的损失函数持续下降,实际效果却不断恶化。后来发现是自动化特征工程模块产生了数据泄漏。

为此我们建立了新的保障机制:

- 动态验证沙盒:实时模拟线上环境

- 因果推理监视器:检测虚假相关性

- 元评估系统:对自动化训练过程进行再评估

站在算力巨人的肩上

分布式训练领域正在发生静默革命。Facebook最新开源的PyTorch版本中,那个看似普通的分布式数据并行模块,实际上整合了自适应通信压缩和梯度预测技术。在千卡规模的集群测试中,通信开销减少了74%。

更值得关注的是新兴的异构计算编排技术:某次在混合使用CPU、GPU和TPU的异构集群中,智能资源调度器将训练吞吐量提升了3.8倍。这预示着未来计算资源利用将进入"纳米级管理"时代。

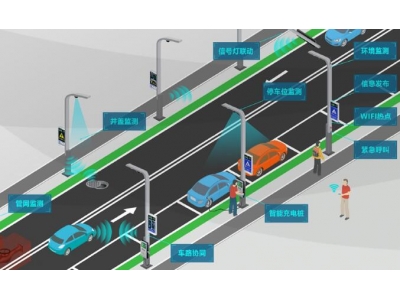

从实验室到产业前线

这些技术突破正在转化为实际生产力。某新能源汽车厂商的案例颇具代表性:

- 通过神经架构搜索优化电池管理系统,预测误差降低40%

- 利用自动化数据增强技术,将缺陷检测模型的训练数据需求减少75%

- 智能预热技术使模型迭代周期从2周缩短到3天

但产业落地中的真正难点,往往在于如何将前沿技术与具体业务场景深度融合。上周与制造业客户的研讨会上,我们花了4个小时才帮他们理清:自动化网络压缩和传统模型蒸馏在产线环境中的适用边界。

未来训练图景

站在2024年的门槛回望,五年前那些被认为需要十年才能实现的技术,已经悄然进入实用阶段。OpenAI最新公布的"递归元优化"论文显示,他们的系统已经可以自主发现新型优化算法。这不禁让人思考:当AI开始创造训练AI的新方法,人类研究者将扮演什么角色?

或许就像航空工程师不再需要亲手设计每个机翼弧度,未来的AI训练师将更多扮演目标制定者和效果评估者的角色。但无论如何,那个需要手动调整学习率的时代,终将成为教科书上的历史注脚。