当我的服务器开始"思考"

上周三凌晨三点,我盯着监控屏上跳动的数据曲线苦笑——这台配备256核EPYC处理器的服务器正在以87%的负载率运行着分子动力学模拟,而隔壁机架的A100集群却在用1/3的功耗训练着新的药物发现模型。这个场景让我突然意识到,算力世界正在上演一场静默的"权力更迭"。

核战争时代的余晖

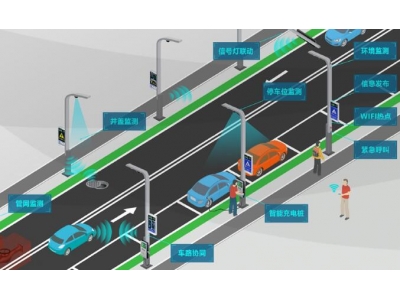

在深圳某自动驾驶公司的机房,工程师小王给我算了笔账:"这套双路256核系统处理完20TB激光雷达点云需要62小时,但用TensorRT优化后的模型在8卡服务器上只需9小时。"他说话时,背后的机柜闪烁着幽蓝的指示灯,像极了传统算力最后的倔强。

这种对比在多个领域愈发明显:

AI芯片的"暴力美学"

记得第一次拆解H100显卡时,我被那个比CPU大五倍的散热模组震撼到了。NVIDIA工程师的豪言犹在耳边:"我们不是在造芯片,是在铸造数字时代的炼金炉。"这种设计哲学正在重塑计算生态:

新旧势力的共生密码

在上海超算中心,我看到了震撼的一幕:神威·太湖之光的40960个申威处理器正在为某AI大模型生成训练数据集。这种传统超算与AI的"混血"应用正在成为新趋势:

未来计算的三重奏

与英特尔架构师的深夜对话让我茅塞顿开:"CPU是管弦乐团,GPU是摇滚主唱,而NPU即将成为电子混音师。"这种异构计算正在催生新的编程范式:

某次技术沙龙上,有位开发者问了个有趣的问题:"如果让ChatGPT来优化OpenFOAM代码会怎样?"我们真的尝试后发现了惊喜——AI不仅重构了部分并行逻辑,还提出了基于物理特性的新型网格划分策略。

突围者的新大陆

在合肥的量子计算实验室,我触摸到了未来计算的温度:

某初创公司CTO的比喻很精妙:"现在的计算架构就像火锅料理——CPU是慢炖的汤底,GPU是爆炒的食材,而量子计算可能是那碟让人惊艳的蘸料。"

站在算力十字路口的我们

当我给大学生们展示如何用8核笔记本微调LLaMA模型时,看到了他们眼中的光芒。这提醒着我们:

就像那天深夜,我偶然发现机房里的256核服务器和AI训练集群通过RDMA网络自发完成了负载均衡——或许这就是算力进化的终极形态:不再是非此即彼的对抗,而是阴阳相济的共生。