黑客攻破自动驾驶系统的那个午后

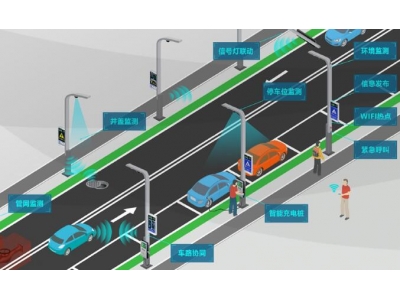

2023年4月12日,特斯拉工程师发现一件诡异的事:某辆测试车在十字路口突然急刹,车载系统显示前方出现根本不存在的移动路障。经过72小时排查,真相令人后背发凉——某个研究团队通过对抗性样本生成技术,在交通标志上粘贴特定图案,成功欺骗了视觉识别算法。

这个真实案例暴露出人工智能系统的致命软肋:当我们教会机器理解世界时,也无意间构建了可被系统性破解的数字巴别塔。作为从业十年的AI安全工程师,我亲历过太多这样的"技术惊魂时刻"。某次压力测试中,一组看似随机的噪声就让医疗影像诊断系统的准确率从98%暴跌至31%。

对抗训练的黑暗艺术

你可能要问:这种攻击很难实现吗?实际上,只要掌握梯度反向传播的奥秘,就能像雕刻家修改黏土般重塑AI的认知。我常用这个比喻:人类大脑处理信息时自带"模糊滤镜",而算法感知世界的方式就像用精密量角器测量树叶纹路——任何细微扰动都会被指数级放大。

- 某银行风控系统将正常交易误判为欺诈

- 工业质检AI把合格产品扔进废品区

- 人脸识别门禁突然拒绝所有员工进入

这些看似荒谬的场景,在对抗性攻击实验中每天都在上演。更可怕的是,现代生成对抗网络(GAN)能让攻击自动化进行,就像培养皿中自我进化的病毒。

技术军备竞赛已打响

去年参与某国防项目时,我们团队研发出"认知防火墙"技术。原理类似于给AI安装精神疫苗——在训练时主动注入对抗样本,让系统学会识别数据中的异常扰动。但三个月后,攻击方就研发出能绕过防护的三维物理攻击,通过在实物表面雕刻特定纹路实现欺骗。

这场攻防战催生出全新的技术生态:

- 防御方开发出动态权重混淆技术

- 攻击方转而研究量子噪声干扰

- 第三方审计机构推出AI系统安全认证

有趣的是,某些电商平台已经开始利用对抗训练优化推荐算法,通过模拟"最难缠用户"来提升系统鲁棒性。这就像让拳击手与自己的全息影像对打,在虚实交错中突破极限。

伦理迷宫中的技术抉择

上个月受邀参加全球AI安全峰会,某科技巨头的首席伦理官抛出一个尖锐问题:当防御技术本身可能被武器化时,我们该如何划定技术共享的边界?这让我想起核能开发的困境——安全算法与攻击手段往往是一体两面。

更现实的挑战来自商业领域。某车企曾拒绝修复已知的算法漏洞,理由是"攻击成本高于车辆本身价值"。这种风险贴现思维,正在制造无数定时炸弹。作为技术专家,我们不得不在股东利益与公共安全之间走钢丝。

或许真正的解决方案在于重构技术哲学。MIT最近开展的"共生AI"项目给了我启发:与其追求绝对安全,不如建立动态平衡机制。就像人体免疫系统,允许适度攻击来维持整体健康。这种范式转变可能需要我们重新定义机器智能的本质属性。

在可预见的未来,这场人机博弈必将催生出新的技术物种。当某天AI系统能自主生成对抗样本进行自我训练时,我们或许会见证技术奇点的另一种形态——不是机器超越人类,而是在对抗中达成新的生态平衡。这条路布满荆棘,但正是这种持续的技术张力,推动着文明向前跃进。