我的摄像头被算法"看穿"了

去年某国际机场的人脸识别系统闹出乌龙,将一名普通旅客识别为通缉犯。当我调取系统日志时,发现攻击者只是在眼镜框上贴了特定图案的贴纸。这种看似儿戏的对抗样本攻击,让价值千万的安防系统瞬间失效。这不禁让我思考:计算机视觉在赋予机器感知能力的同时,是否也打开了潘多拉魔盒?

AI视觉的三重安全困境

在开发智能巡检系统时,我们团队曾遭遇这样的难题:

攻防战中的技术博弈

某自动驾驶公司曾向我们展示他们的防御方案:通过在车载摄像头添加光学滤波器,成功抵御了98%的激光干扰攻击。这种硬件级防护配合对抗训练算法,构建了立体防御体系。更精妙的是他们的动态认证机制——当系统检测到异常视觉输入时,会立即启动多传感器交叉验证。

安全防护的五个关键维度

经历多个项目实践后,我总结出AI视觉安全防护的闭环:

未来战场的新形态

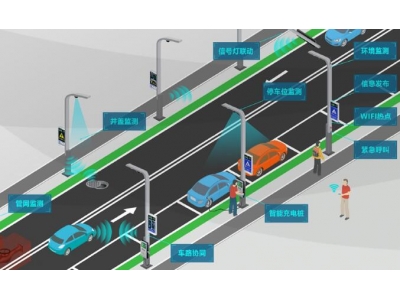

最近测试的AR安防系统给了我新的启示:当攻击者试图用对抗贴纸欺骗监控摄像头时,系统自动启动数字孪生验证,在虚拟空间中重建三维场景进行比对。这种虚实交融的防御模式,或将重新定义AI视觉的安全边界。但更值得关注的是量子成像技术的突破,它可能从根本上解决传统视觉系统的信号欺骗难题。

在开发某智慧城市项目时,我们意外发现:通过分析交通摄像头数据流中的异常波动,竟能提前15分钟预测特定区域的道路塌陷风险。这提示着AI视觉安全研究可能衍生出意想不到的价值——从被动防御转向主动预警,从技术保障升级为风险洞察。当机器的眼睛学会"看见"危险本身,或许我们终将找到安全与创新的平衡点。