当新闻主播变成我的私人定制助手

上周三凌晨两点,我蜷缩在沙发里刷新着手机,突然在央视官网发现了个新功能——人工智能新闻联播直播回放系统。这个支持实时语音交互的智能系统,不仅能像真人主播那样字正腔圆地复述三小时前的时政要闻,还能根据我的浏览记录推荐三农专题报道。更令人惊讶的是,当我随口问及"今年夏粮收购政策",AI立即调出相关报道片段,配合动态生成的3D数据图表进行讲解。

藏在智能回放里的黑科技矩阵

这个看似简单的回放功能背后,实则搭建着三重技术护城河:

- 多模态内容理解系统实时解析主持人的微表情和手势动作,在回放时智能匹配对应的新闻素材

- 语义时空索引技术将每30秒的新闻内容切割为可独立检索的知识单元

- 动态场景重建算法能根据用户设备自动调整虚拟演播厅的布景风格

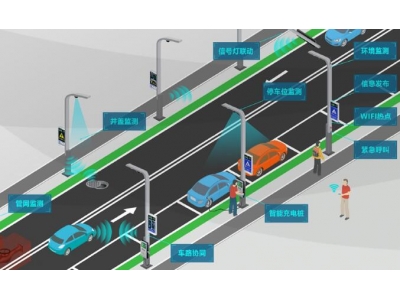

某省级电视台的技术总监向我透露,他们最近在处理突发新闻时,AI系统仅用17分钟就完成了传统团队需要3小时的视频剪辑、字幕生成、多语言适配全套流程。这种实时新闻生产线正在重塑整个行业的作业模式。

那些你意想不到的智能回放应用场景

在走访某市融媒体中心时,我偶遇几位正在测试新功能的视障用户。他们佩戴的智能眼镜通过骨传导技术,将AI主播的手语解说与新闻画面中的关键元素进行空间音频标注。"现在我能'听'到画面里外交部长的手势幅度了",其中一位测试者兴奋地比划着。

更让我惊讶的是教育领域的创新应用。某重点中学的历史老师展示了他们的教学实验:当课堂讲到"一带一路"专题时,AI回放系统能即时调取十年间的相关报道,自动生成对比时间线。学生们还可以用虚拟形象与历史时间线上的AI主播进行问答互动。

当智能回放遇见元宇审:未来的新闻接收方式

在深圳某科技公司的实验室,我提前体验了尚在测试阶段的全息新闻回放舱。当选择"台风路径报道"回放时,整个空间瞬间被气象云图包裹,AI主播的虚拟形象踩着台风眼的动态模型进行解说。更厉害的是,系统能根据我的视线焦点自动放大局部数据,甚至允许用手势"切开"云层查看内部结构。

技术团队透露,他们正在研发的神经交互回放系统,未来可能实现这样的场景:当用户回忆某条新闻时,脑机接口能直接调取AI整理的核心信息片段,像记忆闪回般投射在视网膜上。当然,随之而来的隐私保护与伦理问题,也成为了行业讨论的新焦点。

就在昨天,我收到某AI公司的产品内测邀请。他们的新闻回放系统新增了情绪适配功能,当我选择"晨间模式"时,AI主播会端着虚拟咖啡杯,用更轻松的语气播报要闻;切换到"深夜模式",主播的语速会自动放缓,背景音乐变成助眠白噪音。这种人性化设计,或许正预示着人机协同传播的新纪元。